价格

7次/1$

商业使用

允许

API文档资料

Text2Video-Zero

官方代码实现

Text2Video-Zero:文本到图像扩散模型的零样本视频生成*

Levon Khachatryan,

Andranik Movsisyan,

Vahram Tadevosyan,

Roberto Henschel,

Zhangyang Wang, Shant Navasardyan, Humphrey Shi

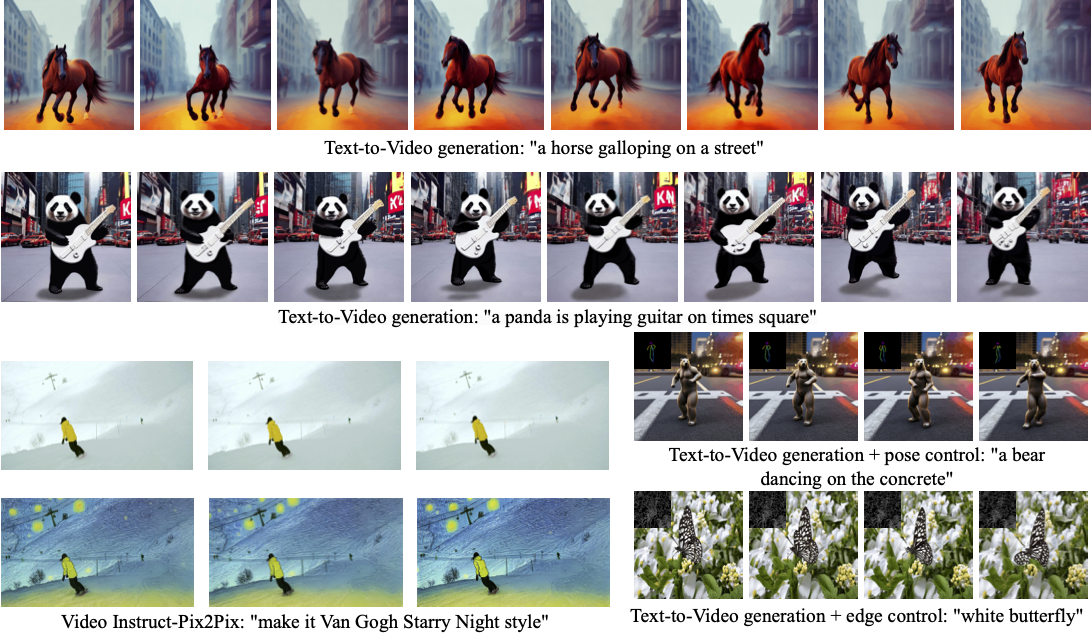

我们的Text2Video-Zero方法支持:(i) 纯文本提示生成视频(见第1、2行),(ii) 结合姿态/边缘引导的文本生成(见右下),以及(iii) 视频指令编辑Video Instruct-Pix2Pix(见左下)。生成结果具有时间一致性,并严格遵循引导信号和文本提示。

相关资源

- 潜在扩散模型实现高分辨率图像合成(即LDM和Stable Diffusion)

- InstructPix2Pix:基于指令的图像编辑学习

- 为文本到图像扩散模型添加条件控制(即ControlNet)

- Diffusers库

- Stable Diffusion的令牌合并技术

许可证

本代码基于CreativeML Open RAIL-M许可证发布。该许可证适用于我们在原始Stable Diffusion代码基础上的所有修改和贡献。原始Stable Diffusion代码采用CreativeML Open RAIL-M许可证,详见此处。

引用文献

如果您的研究使用了本工作,请引用我们的论文:

@article{text2video-zero,

title={Text2Video-Zero: Text-to-Image Diffusion Models are Zero-Shot Video Generators},

author={Khachatryan, Levon and Movsisyan, Andranik and Tadevosyan, Vahram and Henschel, Roberto and Wang, Zhangyang and Navasardyan, Shant and Shi, Humphrey},

journal={arXiv preprint arXiv:2303.13439},

year={2023}

}

使用量分析

总调用次数:41,700

平均响应时间:1.2s

text2video-zero 使用统计

replicate - 调用数据分析

更新时间: 8/14/2025